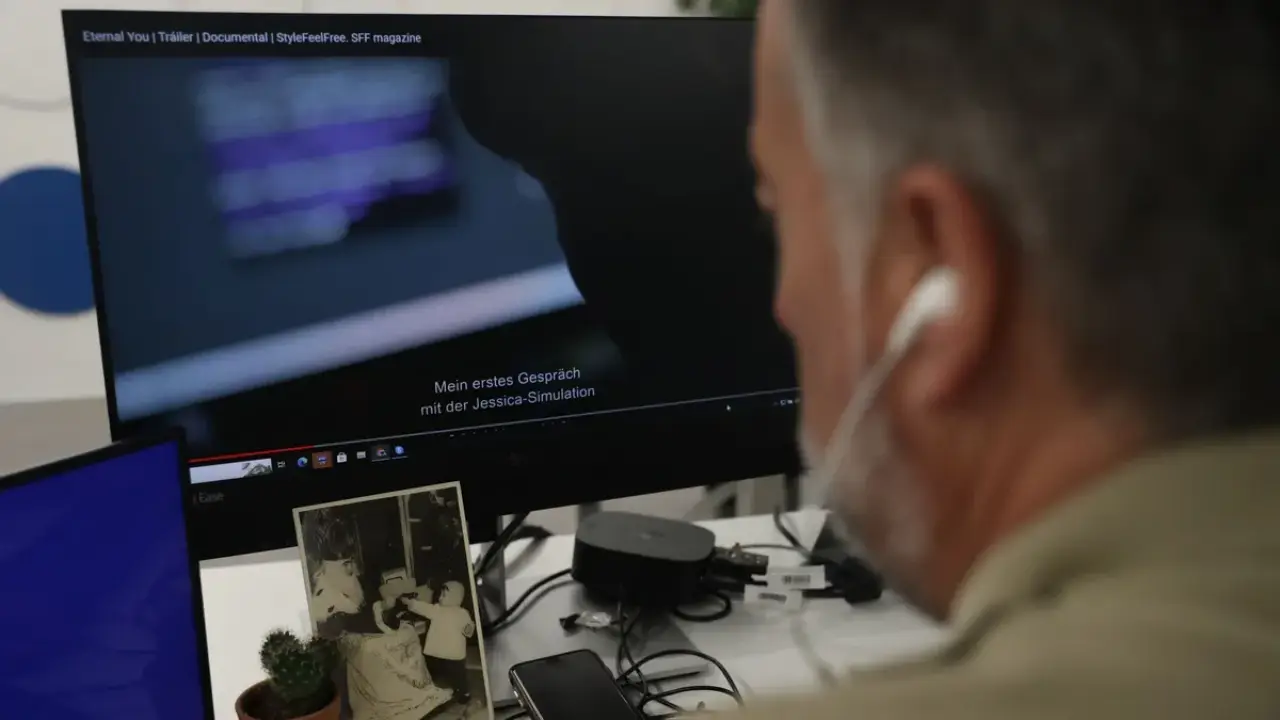

La locura por la inteligencia artificial se ha centrado hasta ahora en los chips fabricados por Nvidia y aplicaciones como ChatGPT de OpenAI. Detrás de este frenesí hay una prisa por construir la infraestructura necesaria para entrenar y ejecutar modelos de IA generativa (GenAI).

La manifestación en el mundo real de la confusión de la IA es evidente en el condado de Northumberland, en el norte de Inglaterra. Allí es donde Blackstone, el mayor propietario de bienes raíces comerciales del mundo, compró en mayo 95 hectáreas de terreno con planes de invertir 13,000 millones de dólares en la construcción de uno de los campus de centros de datos más grandes de Europa.

El sitio abandonado, que una vez albergó una planta de energía, es el primero en la fila para recibir la conexión eléctrica, según una persona familiarizada con el asunto. Sin embargo, eso depende de las negociaciones con la National Grid de Gran Bretaña y de los permisos de planificación de las autoridades locales. Blackstone aún podría retirarse.

El apetito aparentemente insaciable por la IA contrasta con los desafíos más mundanos de construir y operar centros de datos. Estos edificios tipo almacén que albergan servidores y chips se miden por su demanda de electricidad. Los centros de datos denominados “hiperescaladores”, que se utilizan principalmente para el almacenamiento de datos y los servicios de computación en la nube, suelen tener una capacidad de entre 20 y 50 megavatios.

La llegada de GenAI supone una mayor potencia de procesamiento que requiere más electricidad. Una búsqueda de texto en ChatGPT consume tanta energía como la mitad de la carga de un teléfono inteligente, mientras que generar una imagen con un modelo GenAI podría consumir 10 veces más energía que una búsqueda en Google, según un estudio. Los operadores de centros de datos están planeando y construyendo instalaciones con una capacidad de entre 200 y 500 MW. Los analistas de Morgan Stanley estiman que el costo de construir un campus es de 10 millones de dólares por megavatio.

Estos planes están poniendo a prueba la infraestructura energética. Los centros de datos, incluidos los utilizados para minar criptomonedas, absorbieron alrededor de 460 teravatios hora (TWh), o el 2% de la demanda mundial de electricidad en 2022, según, la Agencia Internacional de la Energía.

Te puede interesar: Siemens Energy planea contratar 10,000 nuevos empleados para su unidad de red eléctrica

El auge de los centros de datos revela los límites físicos de la IA

Sin embargo, en algunas zonas la cifra es mucho mayor. Irlanda, donde se encuentran muchas grandes empresas tecnológicas, ha visto cómo la proporción de electricidad consumida por los centros de datos ha aumentado del 5% en 2015 al 18% en 2022. Para 2033, los analistas de Goldman esperan que los centros de datos de IA agreguen 370 TWh de demanda de energía a nivel mundial, equivalente al consumo de energía combinado del Reino Unido y los Países Bajos en 2023.

Una posible solución es construir centros de datos en regiones como Escandinavia, que tienen menos gente, un clima más frío y una gran cantidad de energía hidroeléctrica. Pero los gobiernos de esos países son cautelosos. Suecia, que alguna vez fue considerada un destino privilegiado para los mineros de bitcoins en Europa, eliminó los incentivos fiscales para los centros de datos el año pasado y comenzó a cobrar impuestos adicionales por kilovatio hora (kWh).

Los centros de datos gigantes en lugares remotos pueden realizar la gran cantidad de cálculos necesarios para entrenar modelos de IA. Sin embargo, cuando se trata de usar aplicaciones como ChatGPT, la proximidad física importa. Un usuario que se encuentra a 100 km de los servidores de una aplicación de IA recibirá respuestas más lentas que uno que se encuentra a 10 km de distancia. Si bien un científico puede estar dispuesto a esperar consultas más precisas, los usuarios que buscan una mejor alternativa a Google esperan los mismos resultados instantáneos.

Una opción es readaptar las instalaciones existentes, pero no es nada sencillo. Mientras que los centros de datos establecidos dependen del aire acondicionado para evitar que los servidores se sobrecalienten, los chips más potentes que se utilizan para GenAI pueden requerir sistemas de refrigeración directa de líquido a chip que son hasta diez veces más caros y requieren importantes renovaciones de diseño. La nueva unidad de procesamiento gráfico (GPU) de Nvidia puede hacer que la modernización sea poco económica, según comentó a Breakingviews un operador de centro de datos europeo. La empresa, valorada en 3 billones de dólares, domina el 75% del mercado de chips GenAI.

La combinación de una demanda desenfrenada y una oferta limitada promete una bonanza para los propietarios que alquilen centros de datos a empresas tecnológicas. Los inversores en nuevos proyectos no empezarán a construir sin exigir un rendimiento, calculado como los ingresos esperados como proporción de los costos de desarrollo, de al menos el 8% al 10%. Eso es alrededor de 5 puntos porcentuales más que el rendimiento probable de la adquisición de un centro de datos existente, según un alto ejecutivo del sector inmobiliario.

El efecto dominó de estos costos aumenta los ingresos que los operadores de IA deberán recuperar de sus clientes. También les deja menos margen de error. La magnitud del auge de la IA puede depender tanto de la sofisticación de los modelos de autoaprendizaje como de la capacidad de los operadores de los centros de datos para superar sus limitaciones físicas.

Con información de Reuters.

¿Te gustan las fotos y las noticias?, síguenos en nuestro Instagram